An ein neues Kundenprojekt gehe ich sehr gern mit einer ersten grundlegenden Onpageanalyse heran. Diese verschafft mir einen groben Überblick über die Website und zeigt bestenfalls gleich erste wichtige Todos auf.

Für eine solche Analyse eignen sich SEO Crawler wie Screaming Frog oder SiteAnalyzer. Beide sind grundsätzlich kostenlos verfügbar. Sie müssen lediglich als Desktop Version installiert werden und ermöglichen dann umfangreiche Analysen.

In diesem Beitrag erkläre ich:

- welche Metriken man sich als erstes anschauen sollte

- wo die Vorteile der einzelnen Tools liegen

- welche Schlüsse man aus den Analysen ziehen kann

Auf den ersten Blick

Jede größere SEO Suite setzt heutzutage auf eigene Crawler und bietet damit mehr oder weniger umfangreiche Analysen und Handlungsempfehlungen an. Das erleichtert das SEO Handwerk natürlich enorm.

Für einen ersten Überblick setze ich dennoch gern auf kostenlose Crawler wie Screaming Frog oder den SiteAnalyzer. Ersterer ist allerdings nur für maximal 500 Unterseiten kostenlos. Für größere Webseiten muss man sich hier also die Premiumversion holen.

Die beidem Crawler bieten allerdings nur eine Analyse der IST Situation. Es gibt keine Handlungsanweisungen, wie mögliche Fehler oder Ungenauigkeiten zu beheben sind. In den meisten Fällen erklärt es sich aber von selbst, was jetzt zu tun ist.

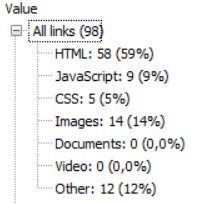

Auf den ersten Blick zeigen die beiden Tools, aus wie vielen Unterseiten die Website besteht, wie viele Bilder, Javascript Dateien oder CSS Files verwendet werden und ob es aktuelle gravierende Fehler gibt.

Fehlerseiten

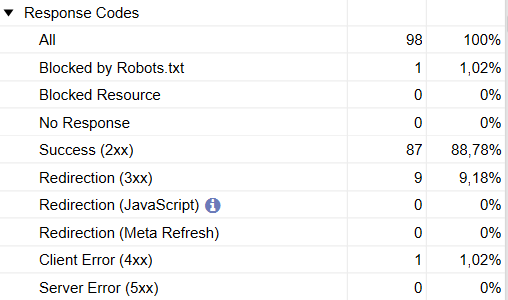

Ein erster wichtiger Punkt, den beide Tools aufzeigen, sind etwaige vorhandene Fehlerseiten. Diese können zum Beispiel serverseitig auftreten und werden dann als 5xx Fehler dargestellt. Sie können aber auch als 4xx Fehler auftreten, wenn es beispielsweise Probleme mit dem Content Management System gibt.

Für Suchmaschinenoptimierer sollte klar sein, dass solche Fehlerseiten die Rankings negativ beeinflussen können. Das trifft insbesondere zu, wenn viele indexiert Unterseiten plötzlich Fehler aufweisen.

Ein erfahrener SEO Experte weiß auch, was jetzt zu tun ist. Für Serverfehler wendet man sich dann an die IT oder den Serverbetreiber. 4xx Fehler werden entweder selber behoben oder an den Webmaster delegiert. Die nicht aufrufbaren Seiten können dann wiederhergestellt oder sinnvoll umgeleitet werden.

Redirects, Bilder

Ein weiterer schneller Blick lohnt sich auf die verwendeten Bilder und Redirects. Auch hier geben die Tools schnell Aufschluss, ob es Potenziale oder Fehler gibt.

Bei den weitergeleiteten Seiten sieht man beispielsweise schnell, ob die korrekte dauerhafte 301 Umleitung eingesetzt wurde oder ob temporäre Umleitungen im Einsatz sind (z.B. 302 und 307 Redirects).

Im Sinne einer konsistenten Umsetzung sollten bei dauerhaften Weiterleitungen auch die entsprechenden 301 Redirects verwendet werden.

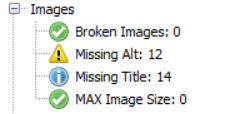

Bei den Bildern gibt eine Crawleranalyse recht schnell Aufschluss darüber, welche Formate eingesetzt werden und wie groß sie sind. Daran lässt sich schnell erahnen, ob die Bilder vielleicht einen negativen Einfluss auf die Ladezeiten haben könnten.

Sollte eine Bildkomprimierung erforderlich sein können Excel Listen mit allen verwendeten Bildern exportiert werden. Diese kann man dann Schritt für Schritt durchgehen und verkleinern. Im Rahmen der Pagespeedoptimierung ist diese Vorgehensweise recht praktisch.

Die SEO Daten

Für uns Suchmaschinenoptimierer sind natürlich die entsprechenden SEO Daten interessant. Hier bieten sowohl Screaming Frog als auch der SiteAnalyzer eine breite Palette.

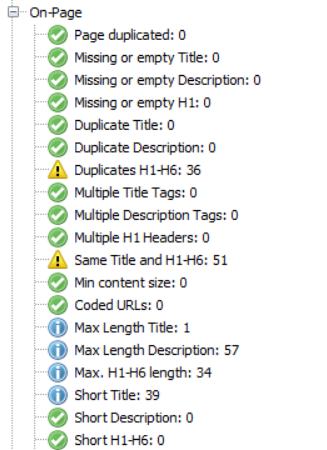

Die Informationen reichen von duplizierten Seiten über Title Tag Längen bis hin zu fehlenden Meta Descriptions. Allein mit diesen Daten kann man bereits etliche Stunden mit SEO Anpassungen füllen.

Im folgenden gehe ich auf einige der wichtigsten SEO Daten ein.

Title Tags und Meta Daten

Die Analyse bringt Aufschluss darüber, ob es Unterseiten gibt, bei denen Title Tags oder Meta Descriptions fehlen oder zu kurz bzw. zu lang sind. Das sind bereits einige wichtige Hinweise. Nach wie vor sind Title Tag und Meta Description sehr wichtig. Immerhin bildet sich aus ihnen das Snippet, das Suchende in den Google Suchergebnissen sehen.

Zu lange Title Tags und Meta Descriptions werden in den Suchergebnissen abgeschnitten. Zu kurze Angaben können dazu führen, dass der zur Verfügung stehende Platz im Google Snippet nicht optimal ausgenutzt wird.

Google geht mehr und mehr dazu über, die Meta Angaben selbständig zu befüllen. Eine fehlende Meta Description wird dann automatisch aus Fragmenten des Contents der Unterseite zusammengestellt. Auch der Title Tag wird häufig umgeschrieben oder ergänzt. Dennoch lohnt es sich, auf sinnvoll befüllte Metadaten zu achten. Im Title Tag sollte auch weiterhin das Fokuskeyword der Site ganz vorne vorkommen und die Meta Description sollte zum Besuch der Seite anregen.

Auch Duplikate bei Title Tag und Meta Description werden erkannt. Es sollte klar sein, dass individuell vergebene Meta Daten Pflicht sind.

Überschriften

Eine solide Überschriftenstruktur zählt nach wie vor als wichtiges Onpagekriterium. Das bedeutet, dass jede Unterseite nur eine H1 und sinnvoll gegliederte Unterüberschriften (H2, H3, H4…) haben sollte.

Es bietet sich an, dass der Keywordfokus einer Landingpage dadurch geschärft wird, dass das Hauptkeyword in der H1 und in einigen Unterüberschriften vorkommt. Auch die Nebenkeywords können in Überschriften untergebracht werden.

Die SEO Crawler zeigen zwar nicht, ob die Keywords sinnvoll in den Überschriften verwendet werden, dafür müsste man ein kostenpflichtiges Tool zu Rate ziehen. Sie zeigen aber, ob irgendwo die Hauptüberschrift fehlt, ob Duplikate verwendet werden und ob die Überschriftenstruktur stimmt.

Auch das Verwenden von mehreren H1 Überschriften wird durch eine solche Analyse aufgedeckt. Es gibt zudem Informationen zu der Länge der Überschriften. Das sollte man im Auge behalten.

Content

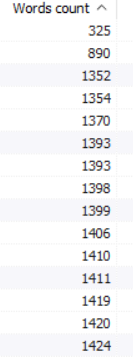

Die kostenlosen SEO Crawler geben keinen Aufschluss über die inhaltliche Qualität des verwendeten Contents. Sie zeigen aber Seiten an, die über relativ wenig Textinhalte verfügen. Als SEO Experte muss man nun selber entscheiden, wie mit den betreffenden Seiten verfahren wird.

Eine Möglichkeit besteht darin, Seiten mit dünnen bzw. wenig Textinhalten zu deindexieren oder gar zu löschen. Dafür sollte vorher genau geprüft werden, ob die über diese Unterseiten Traffic generiert wird.

Für Unterseiten, die ein gewisses Rankingpotenzial haben, also auf Keywords ausgerichtet sind, die über Suchvolumen verfügen, bietet sich eine Contenterweiterung an. Ein einfacher Workflow besteht darin, die Seiten nach aufsteigender Contentmenge geordnet zu exportieren und dann Schritt für Schritt mit mehr Text zu versehen.

Seitenstrukturanalyse

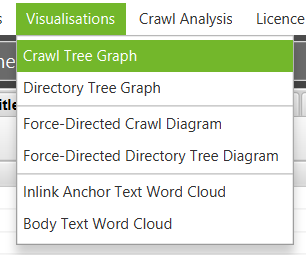

Die Analyse der Seitenstruktur, also wie die verschiedenen Unterseiten unter der Startseite angeordnet sind, ist ebenfalls interessant. Hier bietet Screaming Frog sehr gute Visualisierungen an.

Auf einen Blick lässt sich so feststellen, ob es Unterseiten gibt, die nicht intern verlinkt sind oder sich in der Struktur zu weit weg von der Startseite befinden. Für die Optimierung der internen Verlinkung sind solche Analysen sehr hilfreich.